Almudena Ruiz-Iniesta/ Juan José Cubillas Mercado

El camino hacia una detección precisa del discurso de odio es clave y está lleno de desafíos. Los autores analizan en este quinto capítulo de la serie cómo la inteligencia artificial está ayudando a combatir este grave problema social.

Las redes sociales nacieron como un espacio de opinión donde los usuarios pueden expresarse libremente incluso de manera anónima o con diferentes identidades digitales. Si bien la libertad de expresión es un derecho humano, inducir, provocar y difundir el odio hacia otra persona o personas o colectivos es un abuso de esa libertad.

En España los delitos de odio crecieron un 21% en 2023, además sabemos que, de media, en un día se publican más de 1.000 millones de mensajes entre las seis principales redes sociales (Facebook, X, YouTube, Instagram, TikTok y LinkedIn). En este contexto, la detección automática del discurso de odio resulta crucial como herramienta para monitorizar y prevenir este tipo de mensajes. Sin embargo, nos encontramos ante el problema de que no existe una definición única para el discurso de odio, lo que complica en gran medida la labor de crear algoritmos que detecten el odio automáticamente y con precisión en un texto.

Un mensaje escrito en una red social o un medio digital podrá ser considerado discurso de odio en función de varios elementos que van más allá de las simples palabras que lo componen, como pueden ser las características del propio emisor, su intención, el contexto en el que se realiza, la cultura del país, etc. En otras ocasiones, el mensaje de odio se confunde con el lenguaje ofensivo, pero es importante remarcar la diferencia entre ambos conceptos.

El lenguaje ofensivo se refiere a palabras o expresiones que pueden ser groseras o irrespetuosas, puede incluir insultos, pero no necesariamente buscan incitar a la violencia o la discriminación. El mensaje de odio es una forma más grave de expresión que busca discriminar o incitar a la violencia hacia una persona o un colectivo. Ambos mensajes son perjudiciales, y deben ser detectados, pero el mensaje de odio tiene mayores implicaciones legales y sociales.

Uso de modelos de inteligencia artificial para detectar el odio

El camino hacia una detección precisa del discurso de odio está lleno de desafíos. Los mensajes pueden ser escurridizos y subjetivos, disfrazándose de múltiples formas y desafiando definiciones rígidas. Un mismo mensaje puede resultar inofensivo en un contexto y altamente ofensivo en otro, dependiendo de la intención del emisor, la identidad del receptor y el trasfondo cultural. La línea entre el lenguaje ofensivo y el discurso de odio es tenue pero crucial: mientras el primero puede ser simplemente grosero o insultante, el segundo busca activamente dañar y discriminar.

Para combatir esta amenaza, la inteligencia artificial se ha convertido en un aliado indispensable. El procesamiento del lenguaje natural permite analizar el lenguaje en todas sus dimensiones, desde el sentimiento que evoca hasta las entidades que menciona. A través del análisis de sentimiento es posible identificar emociones negativas que suelen acompañar al discurso de odio, mientras que la clasificación de temas permite detectar patrones dentro de comunidades y grupos donde este tipo de mensajes se propaga.

Durante años, los algoritmos clásicos de aprendizaje automático, como Naive Bayes y Support Vector Machines (SVM), han sido fundamentales en esta tarea. Su eficiencia y rapidez permiten clasificar textos con un nivel aceptable de precisión, ofreciendo además interpretabilidad y facilidad de implementación. Otra de sus ventajas es que requieren menos datos en comparación con modelos más avanzados, lo que los hace útiles en entornos con recursos computacionales limitados.

Sin embargo, estos modelos presentan limitaciones importantes. Tienen dificultades para comprender el lenguaje complejo, el sarcasmo y el contexto en el que se expresan ciertos mensajes. Además, dependen de métodos de representación de texto como Bag of Words o TF-IDF, que no capturan el significado real del lenguaje. A medida que el discurso de odio se ha vuelto más sofisticado y camuflado, ha sido necesario recurrir a modelos más avanzados, capaces de analizar el lenguaje de manera profunda y contextual.

En este sentido, los modelos de lenguaje transformadores, como BERT, GPT y RoBERTa, han marcado un antes y un después. Estos modelos han sido preentrenados con enormes volúmenes de texto, lo que les permite capturar el significado y el contexto de las palabras con una profundidad sin precedentes. Su capacidad para comprender las sutilezas del lenguaje humano los convierte en herramientas poderosas para distinguir entre un simple insulto y un ataque discriminatorio.

A diferencia de los enfoques clásicos, los modelos transformadores pueden identificar patrones más complejos y adaptativos, lo que los hace altamente efectivos en la detección de discursos de odio que antes pasaban desapercibidos.

A pesar de su gran potencial, la inteligencia artificial todavía enfrenta desafíos significativos en este campo. Uno de los principales problemas es la herencia de sesgos en los datos de entrenamiento, lo que puede llevar a decisiones injustas y a la perpetuación de discriminación. Además, la variabilidad del lenguaje, influenciada por factores culturales y sociales, añade otra capa de complejidad.

El discurso de odio es dinámico y evoluciona constantemente, lo que exige una vigilancia continua y la actualización periódica de los modelos para evitar que se vuelvan obsoletos. También es crucial encontrar un equilibrio entre la detección efectiva del odio y la preservación de la libertad de expresión, evitando la censura injustificada o el silenciamiento de voces legítimas.

En conclusión, los modelos de lenguaje avanzados representan una herramienta poderosa en la lucha contra el discurso de odio en línea, pero su éxito depende de nuestra capacidad para mitigar sus sesgos, mejorar su precisión y garantizar su uso responsable. La construcción de una cultura digital basada en el respeto y la inclusión no es una tarea exclusiva de la inteligencia artificial, sino un esfuerzo colectivo que requiere de la intervención humana, de la regulación adecuada y de la educación sobre el impacto del lenguaje en la sociedad.

Detección del odio en medios de información digital: Hatemedia

El proyecto Hatemedia, desarrollado por UNIR en colaboración con otras instituciones universitarias, y financiado por el Ministerio de Ciencia, Innovación y Universidades y la Agencia Estatal de Investigación, nace con el propósito de comprender mejor las redes y los procesos de difusión de las expresiones de odio en los entornos digitales que generan los medios informativos digitales en España y, detectar y monitorear estas expresiones.

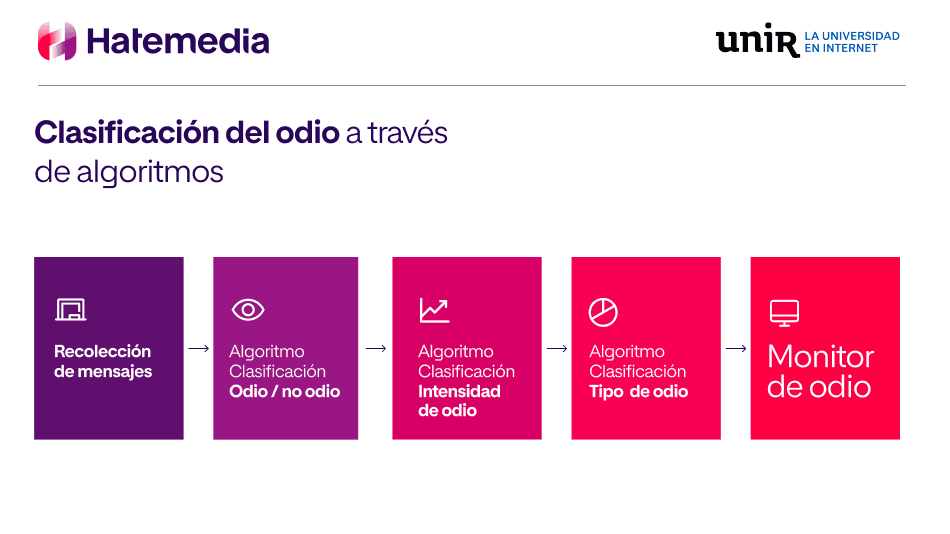

Uno de los resultados de Hatemedia para la detección de expresiones de odio son los algoritmos de clasificación empleados. Estos algoritmos han sido entrenados con otro de los resultados del proyecto, un dataset de mensajes publicados en diversas redes sociales y medios de información social, recopilado a lo largo de la vida del proyecto junto con la librería de expresiones de odio.

Como decíamos el principio, los mensajes de odio son complejos de detectar, ya que pueden ir desde un mensaje con lenguaje ofensivo, pero que no dirige odio hacia ningún colectivo o persona en concreto, a mensajes de odio con amenazas. Esta complejidad del discurso de odio plantea un reto en la detección, ya que tan importante es detectar si en el texto hay alguna expresión de odio como si el mensaje completo constituye un mensaje que promueve el odio.

Para poder entender mejor el odio que se vierte en los medios digitales, desde Hatemedia se plantea una clasificación multietiqueta de los mensajes. La primera etiqueta que se otorga a los mensajes es si contienen odio o no, y después pasamos a identificar el tipo de odio y la intensidad de este. El tipo de odio está referido al colectivo o grupo al que va dirigido el mensaje, y diferenciamos los siguientes tipos: político, misógino, sexual, racial y general.

Por su parte, la intensidad de odio nos permite identificar si un mensaje contiene lenguaje ofensivo, es decir, que no incita directamente a la violencia o por su parte es un odio asociado a amenazas veladas o explícitas. En este sentido, distinguimos cuatro intensidades de odio: mensajes incívicos, mensajes mal intencionados o expresiones abusivas, odio asociado a insultos y amenazas.

Aquí puedes ampliar la imagen.

Aquí puedes ampliar la imagen.

Para las tres clasificaciones propuestas se han empleado algoritmos de machine learning con diferentes ajustes. Para el caso de la detección de odio o no odio en un mensaje, todos los algoritmos utilizados han obtenido exactitudes cercanas al 90%.

En el caso de la clasificación de tipos e intensidades, se tuvo que enriquecer el dataset con diferentes técnicas de sobremuestro, al existir un desbalanceo en las clases que no permitía clasificar correctamente todas ellas. En el caso de la detección de tipo de odio, el mejor de los algoritmos empleados que fue un modelo entrenado con BERT que obtuvo un valor de exactitud en la clasificación del 77%. Finalmente, en la detección de intensidades de odio el modelo obtuvo un valor de exactitud en la clasificación del 70%.

Estos primeros resultados generados por Hatemedia demuestran que es posible hacer una detección automática del discurso del odio, y que mientras los delitos de odio sigan siendo un problema social es necesario contar con herramientas automáticas que promuevan la detección y la prevención de este tipo de mensajes.

El equipo tiene clara conciencia de los desafíos que se le presentan y a través de las líneas de trabajo futuras pretendemos extender la frontera de conocimiento alcanzado en Hatemedia.

Glosario de términos

- Algoritmos: es un conjunto de instrucciones sistemáticas, ordenadas y finitas diseñadas para resolver un problema o realizar una tarea específica. Estas instrucciones están estructuradas de manera que, a partir de una entrada (input), se ejecutan una serie de pasos para producir una salida (output) determinada.

- Técnicas de clasificación automática: son métodos que utilizan algoritmos de aprendizaje automático para categorizar datos en diferentes clases o categorías. Estas técnicas se basan en el análisis de patrones y características dentro de los datos, permitiendo asignar etiquetas de manera automática. Existen distintos enfoques para la clasificación, incluyendo algoritmos tradicionales como Naive Bayes y Support Vector Machines (SVM), así como modelos avanzados basados en redes neuronales profundas, como BERT, GPT y RoBERTa, utilizados principalmente en el procesamiento del lenguaje natural.

- Machine learning: es un subconjunto de la inteligencia artificial (IA) que se enfoca en el desarrollo de algoritmos que permiten a las computadoras aprender a partir de datos y mejorar su desempeño con la experiencia, sin necesidad de estar programadas explícitamente para cada tarea. Estos algoritmos identifican patrones y relaciones en grandes volúmenes de datos, lo que les permite hacer predicciones y tomar decisiones basadas en el análisis de la información. Existen diferentes tipos de machine learning, como el aprendizaje supervisado, no supervisado y por refuerzo, cada uno con aplicaciones específicas en diversos campos.

(*) Almudena Ruiz-Iniesta es doctora en Ingeniería Informática, ha compaginado su actividad investigadora y su carrera profesional trabajando como data scientist en diversas startups. Miembro del equipo investigador a cargo del proyecto Hatemedia. Sus principales líneas de investigación son el big data, data science, machine learning. Es autora de publicaciones científicas en medios nacionales e internacionales y revistas de relevancia.

(*) Juan José Cubillas es un profesional con doble perfil en el ámbito de la informática, ocupando varios puestos de project manager y como responsable técnico en proyectos de I+D+i. Es investigador en el ámbito de la inteligencia artificial y la minería de datos. Colaborador externo del proyecto Hatemedia. Sus principales líneas de investigación se centran en la minería de datos e la inteligencia artificial.

Los capítulos anteriores de la serie:

- Cómo detectar y prevenir el odio en los medios de comunicación digitales a través de Hatemedia.

- El abecé de la desinformación y el odio: claves para entender y combatir las amenazas digitales.

- Las mujeres que ocupan cargos políticos, principales destinatarias del odio en las redes sociales.

- Odiadores en las redes: cómo operan, se organizan y afectan a la opinión pública.

Consulta aquí la última entrevista a Elías Said-Hung publicada en UNIR Revista.

- Escuela Superior de Ingeniería y Tecnología

- Facultad de Educación

- Facultad de Empresa y Comunicación