Daniel Moro Vallina

En un comienzo el análisis estaba integrado en la rama de la musicología histórica, pero pronto se convertiría en una forma de ver las obras como una estructura autónoma e independiente del contexto sociocultural.

Aunque podemos rastrear sus orígenes desde mucho antes, la disciplina del análisis musical se institucionalizó a finales del siglo XIX, coincidiendo con el nacimiento de la musicología o Musikwissenschaft de la mano de teóricos como Guido Adler. Si bien en un comienzo el análisis estaba integrado en la rama de la musicología histórica, ligado al estudio del estilo clásico, pronto se convertiría en una forma de ver las obras como una estructura autónoma, independiente del contexto sociocultural y explicable en términos puramente técnicos.

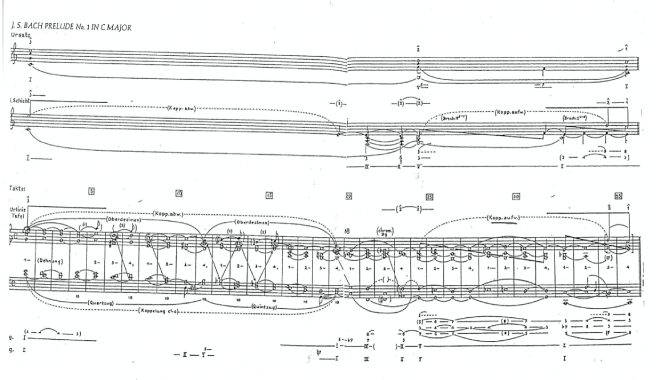

Esta glorificación de la estructura responde a la “ideología del organicismo” (Samson, 2010), que encontramos de manera sobresaliente en analistas como Heinrich Schenker (1868-1935): esto es, la consideración de la obra como un ente orgánico que reproduce el principio de unidad observable en la naturaleza, según el paradigma positivista del siglo XIX. Schenker concibió buena parte del repertorio clásico-romántico como la manifestación de una misma Ursatz o estructura fundamental: un bajo armónico y una línea melódica que, a través de diversos niveles de reducción, se iniciaba y concluía siempre en la tónica.

Hoy en día, no resulta difícil realizar una crítica fundamentada a este tipo de análisis por su carácter prescriptivo, reduccionista e inductivo: más que interesarse por explicar qué hace una obra diferente a otra, Schenker parecía utilizar la música como excusa para validar la coherencia interna de su método.

Ejemplo 1. Reducción schenkeriana del Preludio BWV 846 de J. S. Bach.

Según fue avanzando el siglo XX, el análisis se tiñó de un halo de cientificismo tratando de otorgar un fundamento más sólido a sus procedimientos. En este proceso, tomó prestadas de otras disciplinas algunos principios que darían lugar a metodologías como el análisis prolongacional de Leonard Meyer, de enfoque psicológico; el análisis distribucional y el sintagmático-paradigmático de Nicolas Ruwet y Jean-Jacques Nattiez, derivado de la lingüística; o la Pitch-Class Set Theory de Allen Forte, con una fuerte dependencia interdisciplinar respecto al álgebra.

Partitura y sonido

A pesar de esta variedad metodológica, definimos el análisis como “la resolución de la estructura musical en elementos constituyentes relativamente más simples, y el estudio de la función de estos elementos en dicha estructura” (Bent, 1980/2001). En casi todos los enfoques analíticos tradicionales ha estado presente la idea de segmentación y reducción, por un lado; y el estudio de la función o relación entre los elementos seleccionados previamente, por otro. ¿Cuáles son las limitaciones de adoptar este procedimiento?

El principal problema radica en considerar la partitura como manifestación última de la música, objeto único al que el analista debe prestar atención.

De esta manera, perdemos de vista la realidad física del sonido, objetivándolo en una estructura abstracta e ideal; y, también, obviamos la respuesta emocional y necesariamente individual de cada oyente, presuponiendo que lo que descubrimos en la partitura es percibido de la misma forma por el oído.

La introducción del ordenador ha alterado profundamente estos presupuestos. Desde el estudio estadístico sobre el grado de disonancia en las misas de Josquin Desprez (Patrick y Strickler, 1978), pionero para su época en el uso de un programa informático para el cálculo de notas, el denominado Computer Music Analysis (CMA) no ha dejado de crecer e incorporar conceptos de acústica, física, matemáticas, semiótica, inteligencia artificial o teoría de la información a nuevas formas de comprender el fenómeno musical. Ante el vasto panorama que hoy se presenta (véase la revista Computer Music Journal, por ejemplo), podemos delimitar tres cambios o nuevas perspectivas del análisis musical:

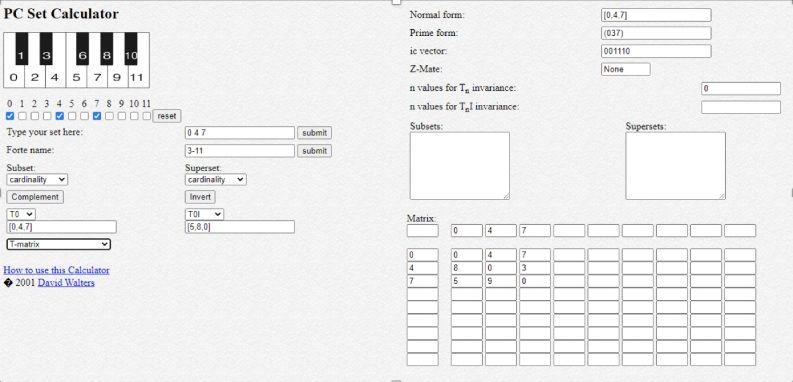

En primer lugar, el uso del ordenador para acelerar el proceso de análisis. Sin plantear un cambio de paradigma en el procedimiento de segmentación y estudio de las unidades estructurales —alturas, escalas, unidades rítmicas—, existen multitud de herramientas que hacen más fiable y objetivo un análisis, digamos, de tipo tradicional. En el caso de la citada PC Set Theory, existen páginas web que permiten calcular el orden normal, la forma primaria o el vector interválico de un set determinado, por citar algunos de los conceptos manejados por Allen Forte en su libro The Structure of Atonal Music (1973).

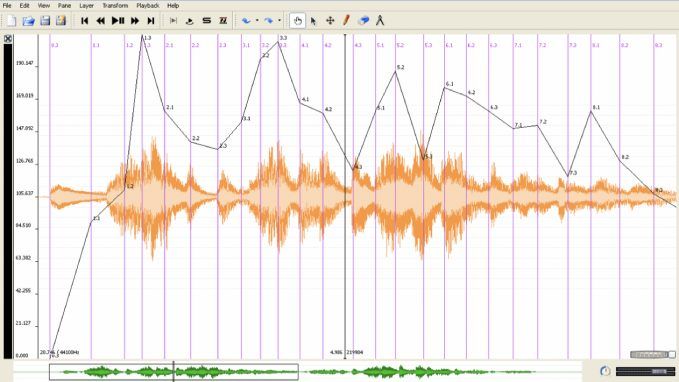

En segundo lugar, la atención hacia aquellos detalles “invisibles pero audibles” que no pueden ser registrados en una partitura convencional, pero que influyen poderosamente en la audición. Aquí hablamos del análisis performativo y la observación de parámetros como el tempo, la dinámica o la articulación. Sonic Visualiser, un programa desarrollado en el Centre for Digital Music de la Queen Mary University of London, permite observar la evolución temporal de estos parámetros a través de diversas capas de espectrogramas o estudiar el rubato mediante la extracción de gráficos de tempo y dinámica.

Así, el analista trabaja directamente con una grabación de audio, y a partir de ella puede reflexionar sobre las variaciones interpretativas de un repertorio a lo largo del tiempo; reconstruir los criterios de instrumentación de una obra en particular; o volver a la partitura para extraer nuevas conclusiones sobre cómo escuchamos la estructura musical.

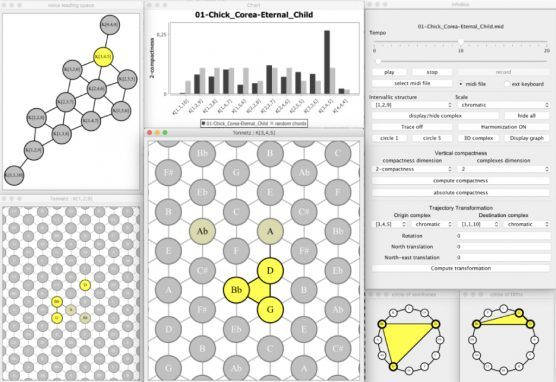

Un último cambio atañe a la reformulación de viejas teorías o la aparición de otras nuevas. Aquí podemos citar la teoría neo-riemanniana desarrollada por David Lewin en su libro Generalized Musical Intervals and Transformations (1987). Aplicando la noción matemática de transformación al sistema tonal, Lewin centra su atención en cómo se sale de un acorde para llegar a otro; dicho de otro modo, estudia la trayectoria de modulación de una pieza determinada. La aplicación HexaChord introduce nuevas formas de visualización a partir de la carga de un archivo MIDI. De esta manera, los acordes ya no se etiquetan individualmente respecto a una tónica dada, sino que se contemplan como movimientos geométricos en una red (denominada Tonnetz) que se despliega sincronizada con el audio.

Son algunas de las herramientas y nuevas formas de análisis que se estudian en la asignatura Análisis Musical Informatizado del Máster Universitario en Investigación Musical de UNIR.

Referencias bibliográficas

Bent, I. D. (1980/2001). “Analysis”, Grove Music Online. Recuperado de: https://www.oxfordmusiconline.com/grovemusic/view/10.1093/gmo/9781561592630.001.0001/omo-9781561592630-e-0000041862Cook, N. (1999). “El análisis desde la perspectiva psicológica de Leonard Meyer”. Quodlibet, 13, pp. 90-105.Cook, N. (1999). “¿Qué nos dice el análisis musical?” Quodlibet, 13, pp. 54-70.Forte, A. (1973). The Structure of Atonal Music. New Haven: Yale University Press.Lewin, D. (1987). Generalized Musical Intervals and Transformations. Oxford: Oxford University Press.Nattiez, J-J (1990). Music and Discourse. Toward a Semiology of Music. Princeton: Princeton University Press.Patrick, P. H. y Strickler, K. (1978). “A Computer-Assisted Study of Dissonance in the Masses of Josquin Desprez”, Computer and the Humanities, 12, pp. 341-364.Samson, J. (2010). “Analysis in context”, en N. Cook y M. Everist (eds.). Rethinking Music (pp. 35-54). Oxford: Oxford University Press.