Carlos Rodríguez Muiños

La computación de alto rendimiento, que usa potentes ordenadores de forma individual o agregada, es capaz de resolver problemas muy complejos en ciencia, ingeniería y gestión. Una especialidad con un futuro profesional prometedor.

Aunque son muchos los campos de aplicación de la disciplina, que no ha dejado de crecer y ganar interés en su uso, estudio, divulgación y empleo, hay dos en los que ha supuesto un antes y un después.

High Performance Computing aplicado al Método de los Elementos Finitos en el ámbito mecánico y estructural

El método de los Elementos Finitos (MEF o FEM, según siglas en inglés) se basa en descomponer un objeto bidimensional o tridimensional en geometrías elementales, como tetraedros o cubos, con sus vértices conectados a través de nodos en una malla densa, a los que aplicar el principio de los trabajos virtuales y componer matrices de gran tamaño que relacionen la rigidez del elemento, los esfuerzos y los desplazamientos.

Resolver estos complejos sistemas matemáticos a través de este sistema matricial permite simular el comportamiento de uno o varios cuerpos ante cargas externas o internas, para obtener una previsión de las tensiones y deformaciones de los objetos, así como información dinámica del mismo (como reacciones a armónicos y cálculos modales) sin tener que hacer una costosa prueba real.

Aplicaciones comunes son el cálculo dinámico de estructuras para la supervivencia a catástrofes naturales (seísmos, maremotos) o provocadas (explosiones y otros ataques), el cálculo para la optimización de los álabes de turbomáquinas o de perfiles de ala de aviones y helicópteros, simulaciones de túnel de viento para carrocerías de competición, etc.

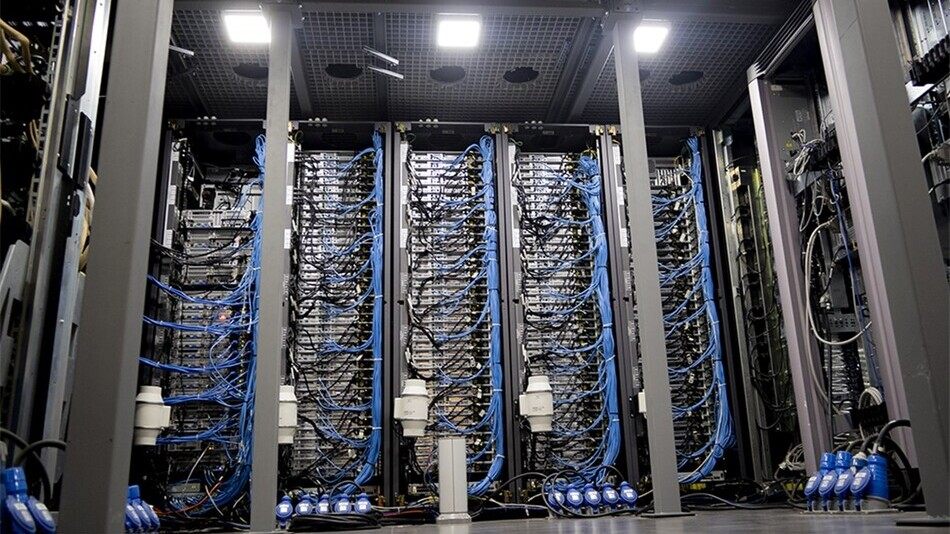

La cantidad de memoria RAM necesaria para efectuar un cálculo modal de una de estas simulaciones es tan grande que es necesario emplear supercomputadores o granjas de cálculo distribuido para poder abordarlo, así como sistemas multi CPU y multi GPU para que los cálculos se puedan realizar en periodos de tiempo razonables.

Muchas Universidades públicas cuentan con este tipo de supercomputadora (como el MareNostrum, el Fisterra o Caléndula), pero también hay centros privados con este tipo de recurso, normalmente ligados a la industria Aeronáutica y de Defensa, como SASCorp.

Algunos paquetes de software incluyen licencias y configuraciones específicas para ellos como es el caso de AYSNS.

Un especialista en HPC tiene dos escenarios de trabajo dentro de este sector:

- De una parte, el técnico IT en microinformática encargado de la configuración del sistema operativo y de la comunicación master – nodo, de tal manera que el cálculo distribuido sea posible.

- De otra, el experto en simulación, que ha de comprender el funcionamiento de los algoritmos para la elección del óptimo de cara a la resolución acelerada de la simulación.

Por supuesto un tercer escenario sería el desarrollo optimizado de los solver e hidrocódigos que emplean softwares de cálculo como ANSYS, propio de doctores en computación de potentes centros de I+D, como los de Livermore de DARPA, si bien esto está alejado de la realidad laboral y refleja sólo el zenit de desempeño de un egresado

High Performance Computing aplicado a la ciencia de datos

La ciencia de datos ha crecido mucho en los últimos años, y durante la última década el tratamiento masivo de la información, big data, ha impuesto necesidades especiales sobre el hardware y el software de tratamiento (preprocesamiento), procesamiento y posprocesado gráfico de imágenes.

A través de tecnologías de cálculo distribuido, cálculo concurrente y cálculo a través de GPU, hoy pueden entrenarse modelos de aprendizaje profundo que hace 15 años eran impensables.

El uso de estos datos, en la generación de modelos, es observable en múltiples tecnologías, citando como ejemplo la creación de chatbots y de asistentes virtuales que han sido entrenados a partir de vastas bases de datos, y con los que, a partir de una práctica llamada transfer learning (transferencia del aprendizaje), pueden emplearse como semillas genéricas para el afinamiento de otros modelos lingüísticos.

El uso de estos modelos, citando como ejemplo el bien conocido BERT, o el de última generación MEGATRON, desarrollado por NVIDIA, han permitido que la traducción de textos sea casi instantánea empleando un simple dispositivo móvil Android con Google Lens, cuyos datos son recopilados y enviados a la nube donde son procesados en vastas granjas de computadores.

Un reciente ejemplo del éxito del procesamiento del lenguaje natural, en este caso mediante el modelo GPT, se puede encontrar en la aplicación ChatGPT que es capaz de resolver problemas que se le puedan plantear y mantener conversaciones coherentes con una gran precisión, y en varios idiomas.

Un especialista en HPC en ciencia de datos trabajará principalmente como desarrollador de aplicaciones de Inteligencia Artificial Distribuida, o en Edge Computing, y aquellos orientados al desarrollo y la investigación tratarán de mejorar los algoritmos actuales.